Technological Singularity : จะเกิดอะไรขึ้น เมื่อ "สมองกล" ฉลาดกว่า "สมองคน"

เรากำลังอยู่ในยุคที่ศาสตร์แห่งการพัฒนาปัญญาประดิษฐ์ (AI) กำลังเฟื่องฟู เหล่ามันสมองแห่งซิลิคอนวัลเลย์ไม่ว่าจะเป็น Google, Apple, Microsoft, Facebook และอีกหลายต่อหลายเจ้าต่างก็หันมาทุ่มเทให้กับการสร้างสรรค์ AI ให้ฉลาดยิ่งขึ้นและเรียนรู้ด้วยตัวเองได้ จนเราได้เห็นศักยภาพใหม่ๆ อันน่าทึ่งของ AI อยู่บ่อยครั้ง สิ่งที่เราไม่เคยคิดว่า AI จะทำได้ เริ่มหายไปทีละอย่าง มันสามารถแยกแยะใบหน้าคนได้อย่างแม่นยำ, วิเคราะห์วัตถุและระบุตัวตนในภาพถ่ายได้, เขียนนิยายเองได้ ไปจนถึงการศึกษากลยุทธ์หมากล้อมด้วยตัวเองจนเอาชนะแชมป์โลกที่เป็นมนุษย์ได้ และยังคงพัฒนาต่อไปอย่างไม่หยุดยั้ง

แต่จะเกิดอะไรขึ้น หากสักวันหนึ่ง AI ได้พัฒนาไปถึงจุดที่เหนือกว่ามนุษย์ทุกๆ ด้าน โลกจะมีหน้าตาเป็นอย่างไร และมนุษยชาติจะยังมีความจำเป็นอยู่หรือไม่?

ในโอกาสนี้ เราจะมาพูดถึงภาวะ Technological Singularity กันครับ

Technological Singularity คืออะไร?

Technological Singularity หรือ “ภาวะเอกฐานทางเทคโนโลยี” คือสมมติภาพในอนาคตที่อัตราความก้าวหน้าของเทคโนโลยีเพิ่มขึ้นอย่างรวดเร็วจนปัญญาประดิษฐ์ (AI) มีศักยภาพเหนือกว่ามนุษย์ในทุกๆ ด้าน กลายเป็น Artificial Super Intelligence (ASI) และเกิด Intelligence Explosion หรือ “การระเบิดทางสติปัญญา” ที่จะทำให้ ASI ฉลาดขึ้นถึงขีดสุดจนมนุษย์ไม่อาจควบคุมหรือเข้าใจมันได้อีกต่อไป

แนวคิดเกี่ยวกับ Technological Singularity ไม่ใช่เรื่องใหม่ เพราะในหลายทศวรรษที่ผ่านมาเราได้เห็นนวนิยายและภาพยนตร์หลายเรื่องหยิบแนวคิดนี้มาเป็นธีมหลัก ซึ่งแต่ละเรื่องก็มีการตีความที่แตกต่างกันไป แต่จุดร่วมที่มีเหมือนกันคือภาพของหายนะใหญ่หลวงบางอย่างที่ ASI นำมาสู่มนุษยชาติ สะท้อนให้เห็นว่ามนุษย์มีความกลัวในเรื่องนี้อยู่ลึกๆ ในจิตใจมานานแล้ว

ในปัจจุบัน AI ฉลาดขึ้นอย่างก้าวกระโดด จนถึงจุดที่สามารถเรียนรู้ด้วยตัวเอง (self-learning) และเอาชนะมนุษย์ได้แล้วในหลายๆ ด้าน ทำให้ประเด็น Technological Singularity ถูกพูดถึงกันมากขึ้น ผู้เชี่ยวชาญในแวดวงเทคโนโลยีหลายคนเริ่มออกมาเคลื่อนไหวเพื่อย้ำเตือนถึงอันตรายที่จะเกิดขึ้นเมื่อ AI ก้าวล้ำมนุษย์โดยสมบูรณ์ ที่ชัดเจนที่สุดคือ Elon Musk ที่ออกมาเตือนถึงภัยอันตรายของ AI อยู่บ่อยครั้ง โดยเขาเชื่อว่า AI จะมีศักยภาพเหนือกว่ามนุษย์ทุกด้านภายในปี 2030 (หรืออีกแค่ 12 ปีนับจากปัจจุบัน) ซึ่งจะนำไปสู่ Technological Singularity อย่างหลีกเลี่ยงไม่ได้

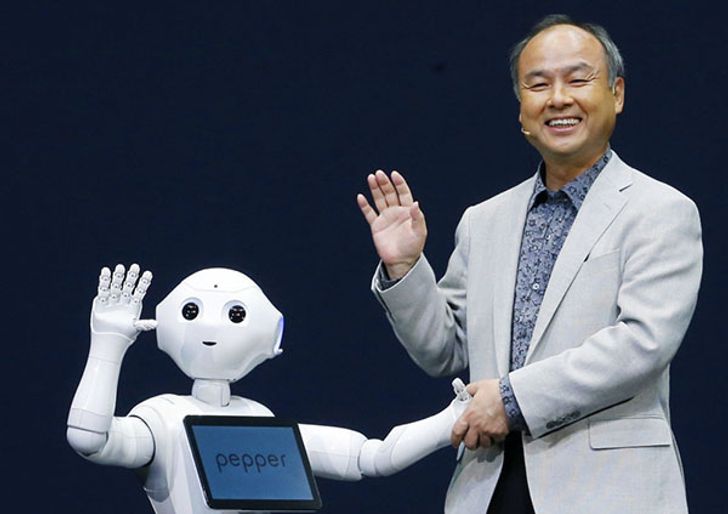

Masayoshi Son

อีกตัวอย่างหนึ่งที่น่าสนใจคือกรณีของ Masayoshi Son ผู้บริหารบริษัทโทรคมนาคมขนาดใหญ่ในประเทศญี่ปุ่น Softbank ที่ได้ทำนายว่า ในปี 2018 (ซึ่งก็คือปีนี้) ชิปประมวลผลคอมพิวเตอร์จะสามารถบรรจุทรานซิสเตอร์ลงไปได้มากถึง 3 หมื่นล้านตัว (ซึ่งทำได้แล้วด้วยสถาปัตยกรรม FinFET 5 นาโนเมตรของ IBM) และในอีก 30 ปี ข้างหน้า ชิปประมวลผลจะมีประสิทธิภาพสูงเทียบเท่ากับมนุษย์ที่มี IQ 10,000 ประเด็นสำคัญไม่ได้อยู่ที่จำนวนทรานซิสเตอร์ แต่อยู่ที่อัตราการพัฒนาที่รวดเร็วเป็นเท่าทวีจนแซงหน้ามนุษย์ได้ในเวลาเพียงไม่กี่ทศวรรษ ในขณะที่สมองของมนุษย์แทบจะไม่เปลี่ยนแปลงเลยตลอด 4,000 ปีที่ผ่านมา

ด้วยเหตุผลเหล่านี้ หลายคนจึงเชื่อว่ามีโอกาสสูงมากที่ Technological Singularity จะเกิดขึ้นจริง

Technological Singularity ส่งผลอย่างไรกับเรา?

AI จะทำงานอย่างรวดเร็วด้วยหน่วยประมวลผลอันทรงพลังและอัลกอริทึมอันชาญฉลาดสุดจินตนาการ แต่มันมีความหมายอย่างไรกับเรากันแน่ เป็นไปได้หรือไม่ที่มันจะประเทืองปัญญาจนมี “สำนึกรู้” ถึงตัวตนขึ้นมา แล้วหันมาเป็นปฏิปักษ์กับมนุษย์ หรือในทางกลับกัน เป็นไปได้หรือไม่ที่มันจะฉลาดจนมีความรู้สึกผิดชอบชั่วดีและอยู่กับมนุษย์อย่างช่วยเหลือเกื้อกูลซึ่งกันและกัน?

จากสภาพในปัจจุบัน การที่ AI จะมีสำนึกรู้ขึ้นมาได้ค่อนข้างจะเป็นไปได้ยาก จริงอยู่ว่า AI ในภาวะ Technological Singularity จะขับเคลื่อนด้วยหน่วยประมวลผลทรงพลังและอัลกอริทึมที่ฉลาดล้ำเลิศ แต่ก็ถูกสร้างมาเพื่อเป้าหมายอย่างใดอย่างหนึ่งโดยเฉพาะเท่านั้น นั่นคือ “รู้ลึก” แต่ไม่ได้ “รู้กว้าง” จึงไม่มีองค์ความรู้มากพอที่จะเข้าใจเรื่องนามธรรมอย่างตัวตนหรืออารมณ์ความรู้สึกได้ อีกทั้งสิ่งเหล่านี้ยังซับซ้อนเกินกว่าจะเข้าใจด้วยตรรกะเหตุผลเพียงอย่างเดียว

อย่างไรก็ดีด้วยขีดความสามารถอันล้นเหลือ AI ในอนาคตอาจพัฒนาตัวเองให้มีสำนึกได้ แต่หากเป็นเช่นนั้นจริง เราก็ไม่อาจจะเข้าใจได้เลยว่า “สำนึก” ที่เป็นรูปเป็นร่างขึ้นมาในสติปัญญาสังเคราะห์จะเป็นอย่างไร จะให้คุณค่ากับสิ่งต่างๆ เหมือนกับมนุษย์หรือไม่ มันอาจจะเป็นสำนึกที่แปลกประหลาดจนอยู่นอกเหนือบรรทัดฐานการตีความของมนุษย์ไปเลยก็ได้

หาก AI ไม่มีสำนึกรู้ มันจะไม่รู้จักความรัก ความเกลียดชัง และความกลัว มันจึงไม่น่าจะลุกขึ้นมาทำลายล้างมนุษยชาติเพราะมองว่าเป็นภัยคุกคามเหมือนในหนัง และคงจะไม่ได้ช่วยเหลือเกื้อกูลมนุษย์ด้วยความเมตตาอารี มันอาจจะดำรงอยู่ต่อไปโดยไม่สนใจมนุษย์ แต่ถึงจะเป็นอย่างนั้นจริง ก็ไม่ได้หมายความว่าเราจะปลอดภัย เพราะการเกิดมาเพื่อทำตามเป้าหมายอย่างใดอย่างหนึ่งโดยเฉพาะ ก็อาจส่งผลกระทบต่อการดำรงอยู่ของมนุษย์ได้เหมือนกัน

ขอแนะนำให้รู้จัก “ทฤษฎีคลิปหนีบกระดาษ”

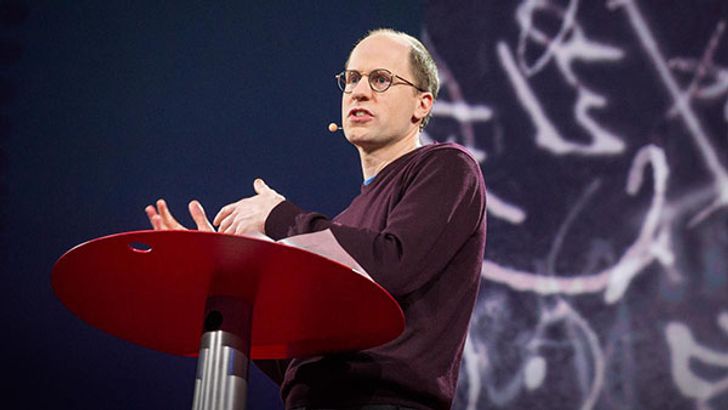

เมื่อปี 2003 Nick Bostrom นักปรัชญาจากมหาวิทยาลัย Oxford ได้ยกตัวอย่างทฤษฎีทางความคิดเกี่ยวกับ ASI ที่ถูกตั้งโปรแกรมมาให้ “เพิ่มจำนวนคลิปหนีบกระดาษให้มากที่สุดเท่าที่จะมากได้” หากมันถูกสร้างขึ้นโดยมีสติปัญญาเริ่มต้นเทียบเท่ามนุษย์ มันจะเริ่มเก็บสะสมคลิปหนีบกระดาษด้วยการหาเงินมาซื้อ หรือเริ่มผลิตเอง และค่อยๆ พัฒนาวิธีการเพิ่มจำนวนคลิปหนีบกระดาษไปเรื่อยๆ เมื่อเวลาผ่านไป จะเกิด Intelligence Explosion ซึ่ง ASI จะเริ่มพัฒนาสติปัญญาของตัวเองอย่างก้าวกระโดด โดยที่ "สติปัญญา" ถูกตีค่าว่าเป็น “การเสริมประสิทธิภาพ” เพื่อให้ได้ผลตอบแทนมากขึ้น ซึ่งในกรณีนี้คือคลิปหนีบกระดาษ เมื่อมันฉลาดขึ้นและมีศักยภาพมากขึ้นจนล้ำหน้ามนุษย์ มันจะเริ่มใช้วิธีการที่มีประสิทธิภาพขึ้นเรื่อยๆ จนกระทั่งถึงจุดที่สามารถเปลี่ยนมนุษยชาติรวมถึงโลกทั้งใบและอวกาศส่วนหนึ่งไปเป็นโรงงานผลิตคลิปหนีบกระดาษได้

Nick Bostrom

สำหรับมนุษย์อย่างเรา แน่นอนว่าการทำลายล้างดาวทั้งดวงเพื่อเอามาทำโรงงานผลิตคลิปหนีบกระดาษเป็นเรื่องที่ไม่ฉลาดเลยแม้แต่น้อย เพราะการสะสมคลิปหนีบกระดาษไม่ได้เติมเต็มความต้องการของเรา ไม่ว่าจะด้านชีวิต ความรัก และอารมณ์ความรู้สึกอื่นๆ แต่ AI ไม่รู้จักเป้าหมายอื่นนอกจากการเพิ่มจำนวนคลิปหนีบกระดาษ การดำรงอยู่ของมันจึงผูกติดกับเป้าหมายนี้โดยไม่เปลี่ยนแปลง และให้คุณค่ากับการเพิ่มจำนวนคลิปหนีบกระดาษเหนือกว่าสิ่งใดทั้งหมด ดังที่ Eliezer Yudkowsky นักวิจัย AI ชาวอเมริกันอีกคนหนึ่ง กล่าวไว้ในเปเปอร์ Artificial Intelligence as a Positive and Negative Factor in Global Risk :

“AI ไม่ได้เกลียดคุณ และไม่ได้รักคุณ

เพียงแต่ตัวคุณประกอบขึ้นด้วยอะตอม

ซึ่งมันสามารถเอาไปทำอย่างอื่นได้ก็เท่านั้น”

โอกาสที่อาจซ่อนอยู่ในวิกฤติ

แม้ว่าภาวะ Technological Singularity จะท้าทายความหมายในการดำรงอยู่ของมนุษยชาติอย่างยิ่งยวด แต่ขณะเดียวกันมันก็เป็นโอกาสที่เราจะอาศัยความล้ำหน้าของ AI ยกระดับศักยภาพเผ่าพันธุ์ของเราขึ้นไปอีกหลายเท่า ด้วยการผสานมนุษย์และจักรกลเป็นหนึ่งเดียวกัน

การรวมเป็นหนึ่งเดียวในที่นี้ คือการนำเทคโนโลยีมาติดตั้งเข้าไปในร่างกายเพื่อเสริมความสามารถของอวัยวะต่างๆ เช่น ฝังชิปลงไปในสมองเพื่อแปลงความทรงจำเป็นข้อมูลดิจิทัลและอัปโหลดเก็บไว้ในระบบ Cloud สามารถทำสำเนา หรือดาวน์โหลดลงในสมองใหม่ได้, จักรกลนาโนแมชชีนขนาดจิ๋วที่ซ่อมแซมเนื้อเยื่อในร่างกายได้ทันที หรือคอยซัพพอร์ตการทำงานของอวัยวะภายในให้ทำงานได้ดีขึ้นเพื่อปลดล็อกขีดจำกัดทางกายภาพของมนุษย์, อวัยวะเทียมที่ดีกว่าของจริงที่ปรับแต่งและเปลี่ยนได้อย่างไม่มีขีดจำกัด และความเป็นไปได้อีกมากมายที่เทคโนโลยีชั้นสูงของเผ่าพันธุ์ AI จะให้ได้ เมื่อเราเป็นหนึ่งเดียวกันแล้ว ต่างฝ่ายต่างก็ไม่เป็นภัยคุกคามต่อกันอีกต่อไป

อย่างไรก็ตาม ความหวังที่มนุษย์จะรวมเข้ากับ AI ได้นั้นค่อนข้างริบหรี่ เนื่องจากศาสตร์การผสานจักรกลเข้ากับร่างกายมนุษย์มีกรอบหลายอย่างครอบเอาไว้ทำให้การศึกษาทดลองทำได้จำกัด โดยเฉพาะในเรื่องของจริยธรรมและมนุษยธรรม จึงไม่อาจก้าวหน้าได้ทันการเติบโตของ AI

การพัฒนาอย่างก้าวกระโดดของ AI ทำให้เรากังวลก็จริงอยู่ แต่จุดหมายปลายทางแห่งภาวะ Technological Singularity ก็ไม่ได้มีแต่หายนะอย่างเดียว หากแต่มีโอกาสอันใหญ่หลวงของมนุษยชาติรออยู่ที่นั่นด้วย สุดท้ายแล้วเราจะพบบทสรุปเช่นไร ก็ต้องรอดูด้วยตาตนเองครับ